Inteligência artificial e as novas políticas das imagens

Publicado em: 5 de abril de 2023

Recentemente, a internet foi tomada por supostas fotos da prisão de Donald Trump. Produzidas no Midjourney, uma plataforma de inteligência artificial, circularam intensamente pelas redes. As fotos eram tão convincentes quanto falsas e dispararam reação imediata da Associated Press, que as contestou publicamente, seguidas de bloqueio automático desse conteúdo no Twitter, Instagram e Facebook e, finalmente, expulsão de seu criador, Eliot Higgins, da plataforma Midjourney. O impacto visual das fotos não é só derivada do seu rigor compositivo, mas também emocional, levando uma multidão online à catarse diante de imagens de uma figura tão polêmica, como Donald Trump, resistindo à prisão e sendo imobilizado por um bando de policiais armados.

Quando tudo parecia mais ou menos estabilizado, um novo tsunami aconteceu, enfeitando as timelines de10 entre 10 esquinas da internet, e tendo como protagonista o Papa Francisco. Trajando um casaco branco super fashion e ostentando um crucifixo brilhante, digno de um videoclipe da Madonna, a foto tornou-se notícia em segundos e, rapidamente, se converteu em meme. O inusitado da cena e alguns detalhes da imagem, como o crucifixo pop e alguns defeitos no processamento das fotos, que resultaram em uma mão ligeiramente borrada e outra um tanto quanto grande, provocaram discussões de todas as ordens sobre receitas de como identificar uma imagem feita com recursos de IA e uma foto verdadeira (se é que isso existe).

Nenhuma tecnologia é neutra e toda fotografia é produto de uma série de instâncias técnicas e programáticas que vão dos modos de enquadrar ao que fica fora do recorte da cena. Há vasta literatura sobre o tema, com as mais diferentes perspectivas de análise, bastando lembrar entre as obras mais recentes, as de Ariella Aisha Azulay e Joanna Zylinska, além do excelente artigo de Ronaldo Entler sobre o estatuto da imagem fotojornalística hoje. Contudo, essas imagens, como as da prisão de Donald Trump e o “desfile” do Papa Francisco, remetem a outras questões, que transcendem essas discussões.

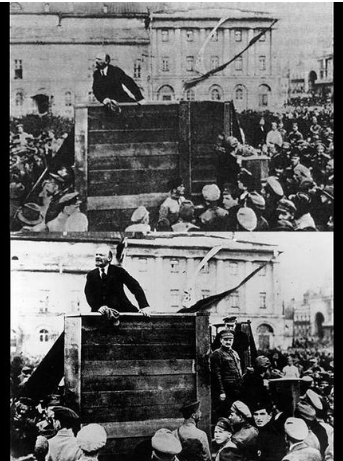

O uso de inteligência artificial vem borrando as fronteiras entre a realidade e a ficção, tornando cada vez mais difícil verificar a legitimidade de fotos e vídeos. Enquanto ainda se debate a ética da manipulação digital, programas inventam imagens verossímeis, com consequências políticas e sociais imprevisíveis. Essas imagens vieram para ficar e não são uma mera atualização do que o estalinismo fez com Trotsky, apagando-o das fotos em que aparecia com Lenin, algo que o nazismo fez em incontáveis outras vezes.

Estamos além da era do “homem sem a câmera” e do mundo pós-Photoshop. O nosso agora é o da imagem sem o humano. A virada não é apenas técnica. Essas imagens mais reais que o real, produzidas com recursos acessíveis de inteligência artificial, como os oferecidos pelo Midjourney e pelo DALLE, colocam em jogo uma outra história do olhar produzida por algoritmos opacos. A pergunta não é se saberemos indicar quais são verdadeiras e quais não são. A pergunta é se os sistemas de visão computacional se tornarão a tal ponto dominantes, que enxergaremos o mundo pelo ponto de vista das IAs e converteremos deepfakes e afins em deeptrues.

Digo deepfakes e afins porque não é preciso, do ponto de vista computacional, chamar essas imagens sintetizadas no Midjourney de deepfakes, pois os métodos usados nesse tipo de plataforma e na produção de deepfakes são diferentes. Enquanto o primeiro é baseado em modelos de linguagem natural e de classificação de imagens, os deepfakes “tradicionais” utilizam métodos generativos que criam novos dados parecidos com os dados de treinamento, a partir dos datasets em que foram treinados. Do ponto de vista das atuais políticas da imagem, no entanto, os diferentes processos confluem para a mesma situação: vídeos ou imagens manipuladas com o uso de algoritmos de aprendizado de máquina para criar a aparência de algo que nunca aconteceu na realidade, expandindo a presença da visão computacional no cotidiano.

A dimensão política, no entanto, não recai na capacidade de ficcionalização ou “fakezização” da imagem. Como assinalei acima, essa é uma questão intrínseca à história da fotografia. A dimensão política reside na matematização do olhar e, especialmente, nas formas como essa matematização pressupõem um processo de padronização dos seus elementos compositivos que podem tanto nos levar a formas inéditas de criação, quanto a um processo que venho chamando de eugenia maquínica do olhar.

Como se sabe, computadores não enxergam. Quando nos referimos à visão computacional, apontamos para um sistema capaz de ler, interpretar e extrair dados de arquivos digitais. Sua aplicação abrange atividades distintas como o OCR (reconhecimento óptico de caracteres), imagens médicas, mecanismos de busca, modelagem 3D, vigilância, biometria, carros autônomos e várias técnicas de edição de imagem. Presentes em diversas atividades, os sistemas de visão computacional funcionam como filtros e lentes do nosso cotidiano, implicando relações de poder e de saber.

Ao “interpretar” o visível, o modelo algorítmico de visão computacional molda campos de visibilidade e invisibilidade. A interpretação, nesse caso, não envolve nenhuma operação hermenêutica. Da mesma forma que os computadores não veem, eles também não entendem as imagens em nenhum nível de representação. A imagem para o computador não tem significado semiótico ou estético. Em termos computacionais, a imagem é uma matriz de pontos e blocos na qual uma IA pode identificar padrões, como arestas, formas, texturas, curvas e cores.

Em sistemas avançados como o Midjourney, essas operações são mobilizadas para criar novas imagens por meio de tecnologias de aprendizado profundo a partir de descrições de texto. Dito de outra forma: você insere uma descrição textual de uma cena ou objeto e o Midjourney tentará produzir uma imagem correspondente. O processo começa com o treinamento do sistema, usando um grande conjunto de imagens e suas correspondentes descrições textuais. Durante o treinamento, o sistema aprende a reconhecer os padrões nas imagens e nas suas descrições para fazer associações entre elas.

É importante ressaltar que quando inserimos um prompt (uma descrição textual) no Midjourney, o programa não passa a “procurar” a imagem correspondente em um banco de dados existente. A criação não é feita com base numa tradução direta dos textos em imagens, mas por meio de uma série de operações matemáticas, que interpretam as descrições textuais como um conjunto de valores numéricos. Ou seja: o sistema não interpreta as palavras em si, mas sim os valores numéricos que são gerados a partir das palavras. Assim, quando solicitamos ao Midjourney para gerar uma imagem de uma “praia ensolarada”, a descrição textual é lida como um conjunto de valores numéricos que representam características, presentes em determinadas imagens com que foi treinado, que remetem a padrões entendidos maquinicamente como areia, mar, sol e guarda-sóis.

Padrão é uma palavra chave para compreender o “pensamento” das IAs. Por lidarem com identificação ou classificação de padrões, os modelos de visão computacional podem, por isso, amplificar tendências e preconceitos presentes nos dados sobre os quais são treinados. Se um conjunto de dados de imagens contiver predominantemente rostos de pessoas brancas, os sistemas de IA terão dificuldades em reconhecer e gerar imagens de rostos de pessoas pretas, indígenas ou asiáticas, como ocorre frequentemente em sistemas de reconhecimento facial. Além disso, o perfil dos dados usados no processo de machine learning tende a perpertuar a sub-representação e a representação estereotipada de certos grupos étnicos ou raciais. É o que chamamos de racismo algorítmico.

Pelos mesmos motivos, os sistemas de IA reproduzem também preconceitos culturais existentes relacionados a gênero, idade, orientação sexual e outras identidades sociais. Se um conjunto de dados de imagens contiver predominantemente imagens de homens brancos em papéis de liderança, como ocorre socialmente e na internet, os sistemas de IA não conseguirão gerar imagens de mulheres em papéis semelhantes.

Diferentemente das imagens químicas, analógicas, as imagens digitais, por serem algorítmicas, não apenas representam coisas, mas podem fazer coisas, executando tarefas, como por exemplo realizar um pagamento a partir de um código QR. Quando submetidas a processos de visão computacional, com tecnologias de imagem, impactam até políticas públicas, decidindo, por meio de triagens automatizadas, quem tem direito ou não a um tratamento de câncer de pele ou prioridade no atendimento no sistema de saúde, como diversos artigos científicos alertam.

As tomadas de decisões automatizadas refletem o enviesamento dos dados utilizados no treinamento do sistema de inteligência artificial e podem afetar nossas formas de ver e perceber o mundo. A presença da visão computacional em quase todos os setores e atividades de nosso cotidiano tende a transformá-la no aparato visual hegemônico de nosso tempo. E é essa mudança que indica a possibilidade de uma era de eugenia maquínica do olhar, baseada em regimes de visão de IA. A hipótese me parece plausível, dado que os cânones do nosso olhar ainda remetem a algumas regras herdadas do Renascimento.

Apesar de reconhecermos a multiplicidade de outros regimes de visão, que não são baseados no sistema perspéctico, e diversas experiências tecnológicas, feitas desde os anos 2000, apontarem para sistemas de projeção sem tela, ainda estamos presos ao cânone clássico do formato retangular dos dispositivos de leitura. Como já aprendemos com Hal Foster, Jonathan Crary e Vilém Flusser, entre outros pensadores da imagem, a visão é um atributo biológico. Mas o olhar é cultural.

Não se trata de aderir a uma história linear do olhar que assumiria o dispositivo perspéctico como fundamento do modelo de visualidade hegemônico desde o Quattrocento italiano. Quando falamos de visualidade, estamos falando de modos de ver, que implicam suas formas de fabricação social. Se a visão é uma atribuição biológica e a visualidade um fato social, o olhar é a interação de ambos, e que define o que é ou não visível no espaço comum.

O olhar, nesse sentido, vai além do campo visual. À medida que confiamos mais em sistemas de IA para processar e interpretar informações visuais, eles podem moldar nossa percepção e interpretação do mundo da maneira como esses sistemas o veem e entendem. O potencial da inteligência artificial para moldar campos de visibilidade não implicará genocídio ou guerras raciais, como fizeram os movimentos eugenistas da primeira metade do século 20. Contudo, seguindo modelos de visão computacional, a eugenia maquínica do olhar pode determinar novas formas de invisibilidade e exclusão social.

As alternativas para melhorar os modelos de visão computacional via curadoria de dados e melhoria nos processos de aprendizado de máquina podem resolver problemas pontuais, mas não o modelo baseado em padrões dos atuais sistemas de inteligência artificial e sua dinâmica de poder e formas de distribuição do visível. É improvável que as IAs sejam capazes de controlar nosso olhar no sentido de nos forçar fisicamente a olhar para algo. No entanto, as técnicas de visão computacional baseadas em inteligência artificial podem influenciar o que vemos, no que prestamos atenção e como moldamos a visualidade. Se a eugenia maquínica se refere ao uso de tecnologia ou máquinas para implementar ou facilitar práticas ou políticas eugênicas, a eugenia maquínica do olhar se refere aos modos de ver seguindo os padrões estabelecidos pelas IAs. É nesse contexto que se anunciam novas questões das políticas da imagem configuradas pela inteligência artificial. Essas questões apontam tanto para uma cultura visual que se expande a partir de parcerias inéditas entre humanos e máquinas, como também evidenciam os riscos de um condicionamento tal em que só enxergaremos aquilo que a visão computacional pré-determinar. ///

Giselle Beiguelman é colunista do site da ZUM, artista e professora da FAUUSP. É autora de Políticas da imagem: vigilância e resistência na dadosfera (2021) e Memória da amnésia: políticas do esquecimento (2019), entre outros. Site: desvirtual.com.